Della tecnologia 5G se ne parla tanto, e non sempre correttamente.

Alcune persone o associazioni hanno deciso che il 5G, lo standard più avanzato per i telefoni cellulari, è un pericolo da combattere.

Proviamo a ragionarci sopra, ma prima dobbiamo mettere le basi, chiarire alcuni concetti, altrimenti rischiamo di fare dei discorsi campati per aria. Ci vuole un po’ di pazienza per capire bene le cose.

In questo articolo non voglio cercare di cambiare le idee di nessuno. La mia intenzione è solo quella di offrire il punto di vista di un tecnico, di uno che ha studiato queste materie e ci ha lavorato per quarant’anni. Gli elementi tecnici base per capirci qualcosa di più li troverete qui, poi ognuno si farà la sua idea.

Premetto che l’articolo è lunghetto. D’altra parte è indirizzato soprattutto a chi non ha competenze specifiche ma assume posizioni critiche. E’ possibile criticare senza sapere? Dire “non voglio il 5G” senza neanche sapere di che cosa si tratta è un atteggiamento (assunto da molti) poco razionale. Oggi, purtroppo, va di moda prendere posizioni “contro” anche senza conoscere veramente le cose. Io resto dell’idea di Luigi Einaudi: occorre conoscere per deliberare.

ONDE RADIO

Viviamo immersi nelle onde radio. La luce è un caso estremo di onda radio naturale, e la luce ci dà la vita. Ma da quando Marconi ha inventato la radio, ci sono altre onde radio di origine artificiale, ovunque. Vediamo le applicazioni che conosciamo meglio:

La Televisione.

Le immagini televisive partono come onde radio dall’antennone che le trasmette e arrivano fino all’antenna sul tetto. Mentre gli apparecchi TV che abbiamo a casa hanno dei livelli di emissione EM irrisori, le antenne centrali invece usano potenze molto alte, dell’ordine di qualche decina o centinaia di kW, per coprire un ampio territorio. Vengono solitamente posizionate in posti molto alti, colline o montagne. A volte in cima ai grattacieli.

Le radio dei pompieri, ambulanze, polizia, tram, treni, quasi tutti i servizi pubblici

Le radio dei sevizi pubblici sono collegate alle centrali di comunicazione tramite onde radio. Stessa cosa per gli aerei. Sia le trasmittenti dei mezzi mobili che quelle delle centrali utilizzano potenze che vanno dai 5 W alle decine o centinaia di W per le centrali.

I walkie Talkie

I walkie talkie, sia quelli dei bambini che quelli professionali comunicano fra di loro tramite onde radio. Hanno emissioni che vanno dai pochi mW per i giocattoli per bambini fino a 5 o 10W per le applicazioni professionali.

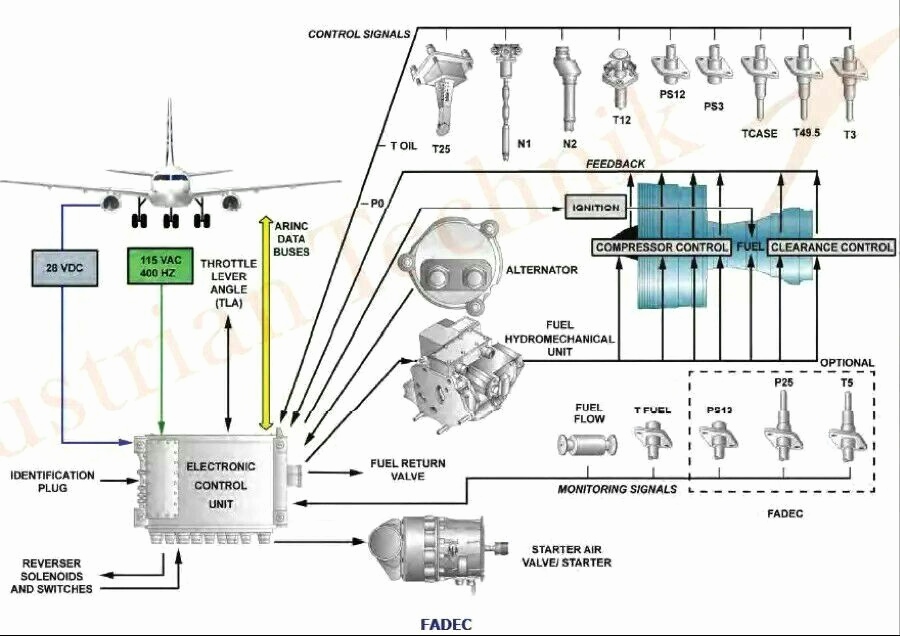

Il RADAR degli aerei

I radar che controllano la sicurezza degli aeroplani utilizzano onde radio nel campo delle microonde. Indipendentemente dalla potenza della trasmissione, la forma a parabola dell’antenna concentra l’emissione in direzione degli aerei, quindi difficilmente può avere un impatto nei confronti delle persone a terra.

I CELLUARI ALL’APERTO

Quando siamo fuori casa i nostri cellulari funzionano collegandosi alle famose antenne dei cellulari, quelle che ci fanno sempre tanta paura. Le potenze in gioco sono variabili in base al numero di utenti e all’area da coprire. Si va da pochi mW per celle molto piccole a migliaia di W per impianti che devono coprire vaste aree.

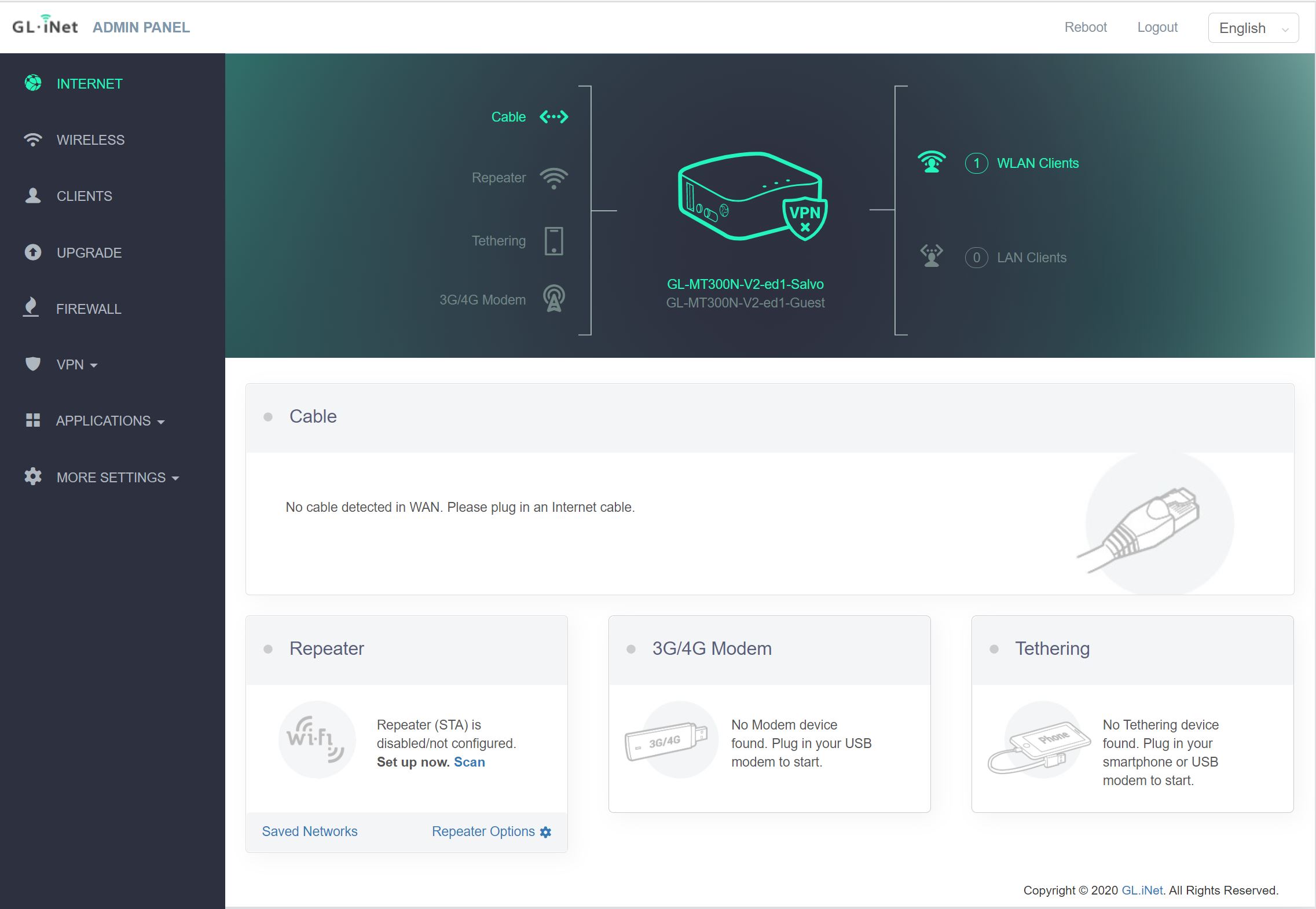

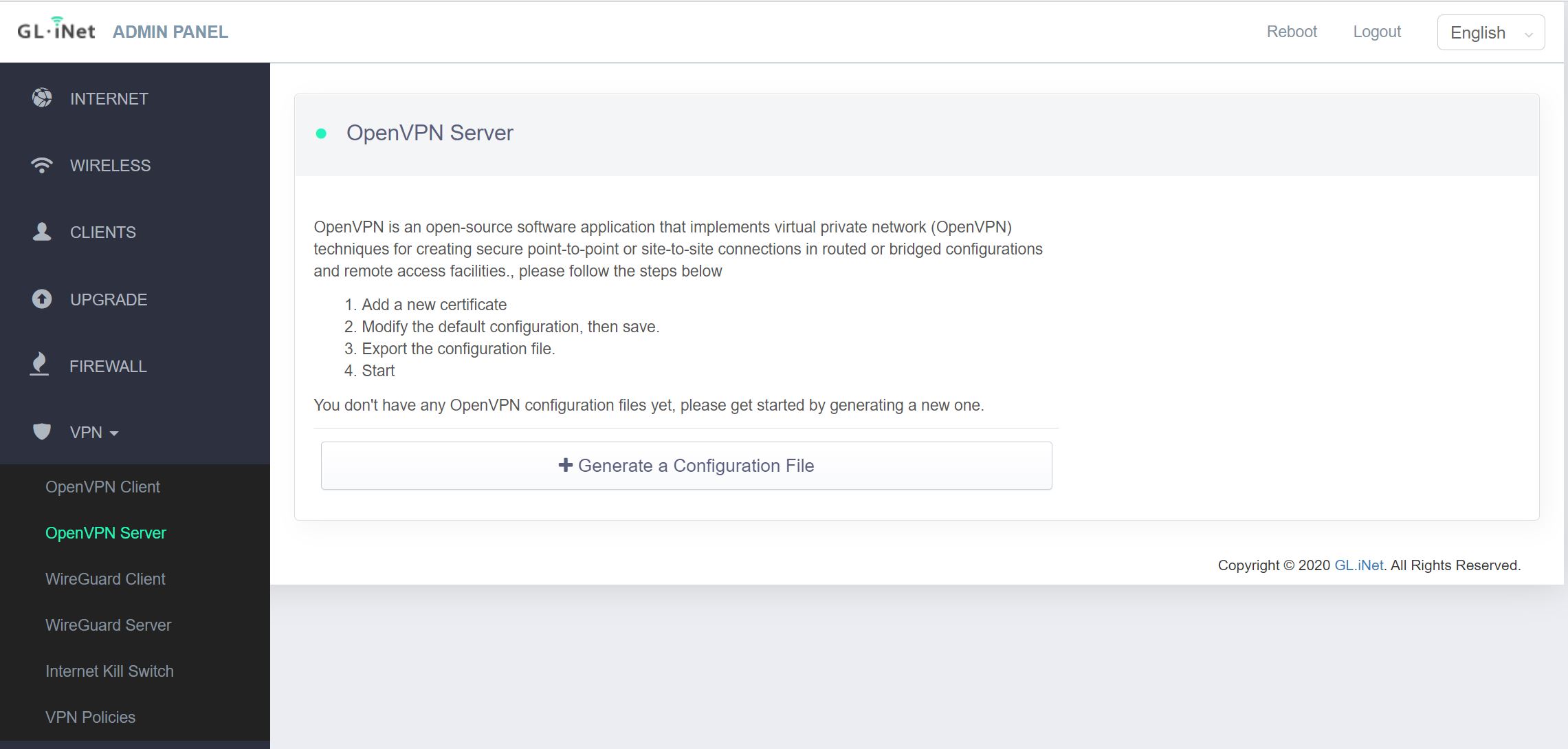

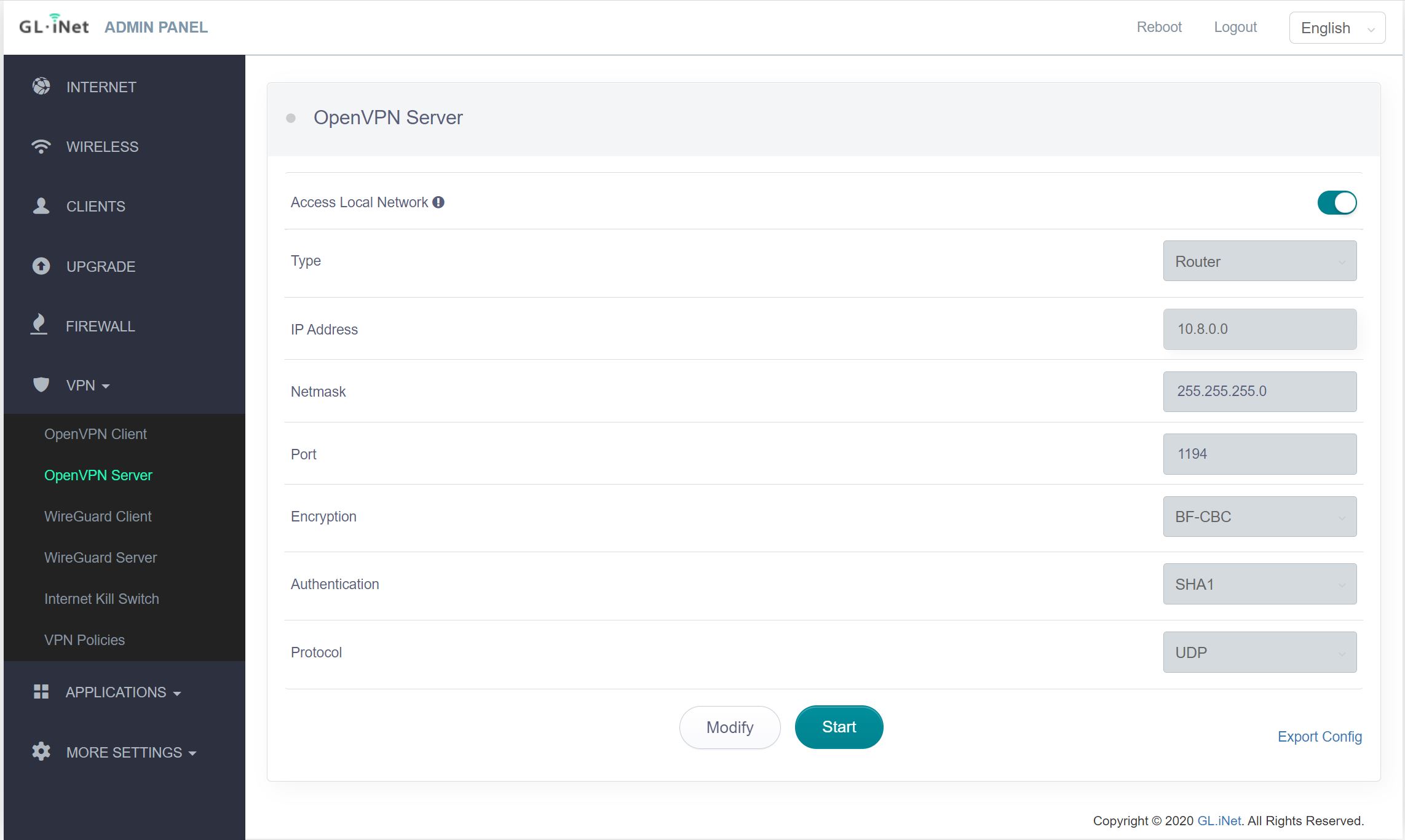

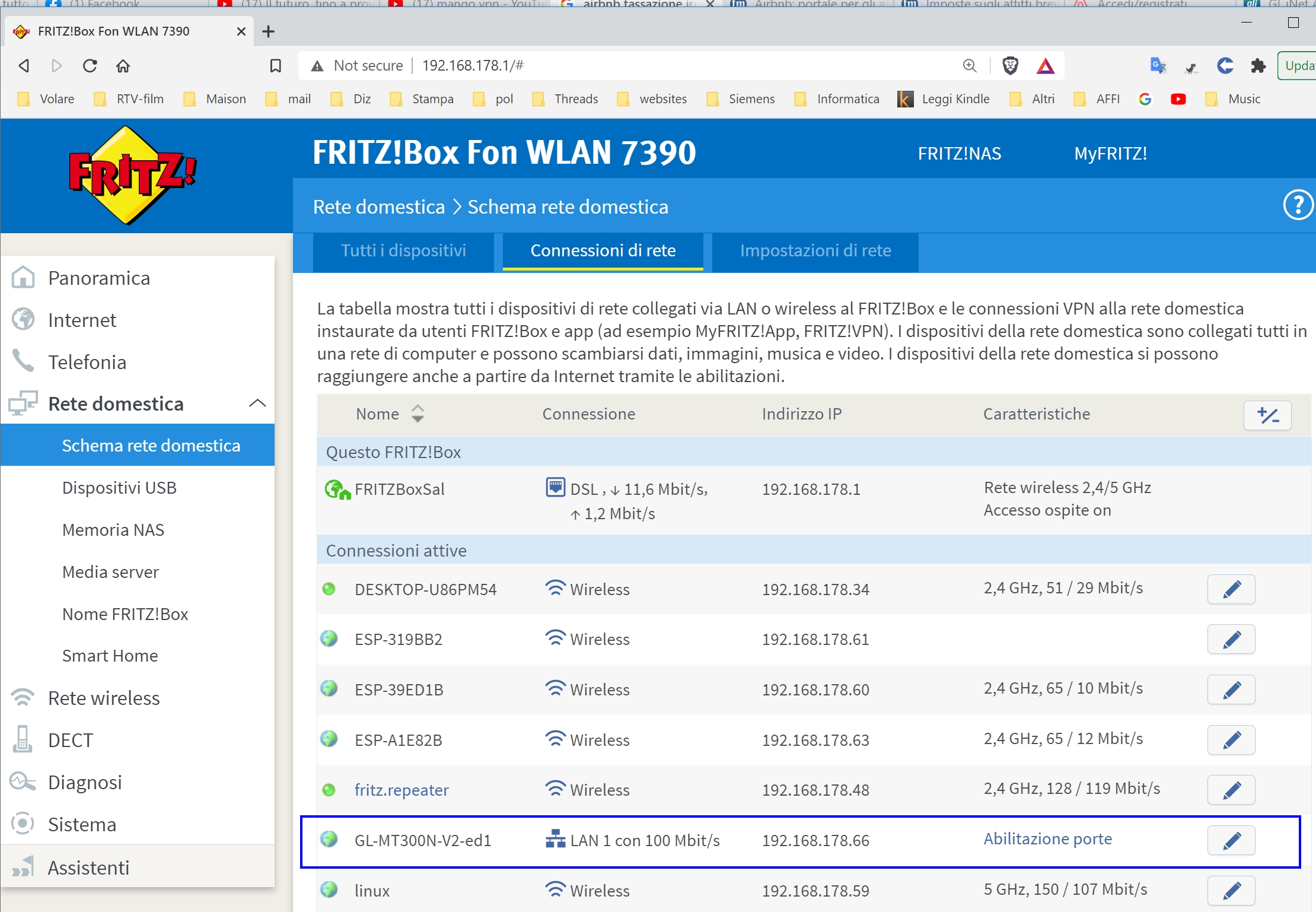

I CELLULARI A CASA

Quando invece siamo a casa i nostri cellulari si collegano al router WiFi di casa, almeno per quanto riguarda l’accesso a internet. Per legge i router per uso casalingo (indoor) possono avere potenza fino a 100mW, quindi molto limitata.

E potrei sicuramente andare avanti per molto, ma penso che si sia capito il significato. Ormai non c’è posto al mondo che non sia inondato da onde radio generate dalle varie apparecchiature che in un modo o nell’altro ci aiutano a vivere meglio, più comodi, più sicuri. Può piacere o non piacere, ma provate a pensare cosa sarebbe oggi la nostra vita senza TV, Radio, WiFi e senza la sicurezza delle varie applicazioni pubbliche (Ambulanze, Pompieri, Polizia, Treni, Navi, Aerei) che si basano sulla radio per le loro comunicazioni. Neanche il navigatore della nostra auto potrebbe funzionare senza le onde radio dei satelliti del GPS.

Per andare avanti quindi dobbiamo essere d’accordo su una cosa: le onde radio ci servono. Neanche nella maggior parte dei villaggi africani si fa a meno della radio. Anzi, più un posto è isolato più ha bisogno della radio per collegarsi al resto del mondo.

Entriamo un po’ nel dettaglio e parliamo quindi delle onde radio, e di due particolari aspetti che accomunano TUTTE le onde radio: frequenza e potenza.

Partiamo da qualcosa che conosciamo bene: il suono. Immaginate due persone che parlano, un uomo con la voce molto grave e una donna con la voce molto acuta. Entrambe le persone possono parlare a bassa voce o urlare. Il tono della voce, grave o acuta, è la frequenza del suono. Il volume (sotto voce o urlata) è la potenza del suono. Un suono quindi può essere grave o acuto e contemporaneamente debole o forte. Situazione analoga per le onde radio che possono avere frequenza bassa e altissima e potenza bassa o altissima. Le due cose non vanno confuse, mente spesso negli articoli che trovate, soprattutto quelli allarmistici, si fa una grande confusione fra frequenza e potenza. Non è infrequente trovare frasi assurde del tipo “una trasmittente della potenza di 600 GHz”. La frase dovrebbe essere “una trasmittente della frequenza di 600 GHz”. Confondere frequenza e potenza potrebbe sembrare un semplice errore, se non ingenerasse in chi legge la sensazione che più alta è la frequenza, più forte e pericolosa è l’emissione. Cosa che è vera solo in parte, solo agli estremi più alti della frequenza, là dove le onde radio diventano radiazioni ionizzanti.

FREQUENZA DELLE ONDE RADIO

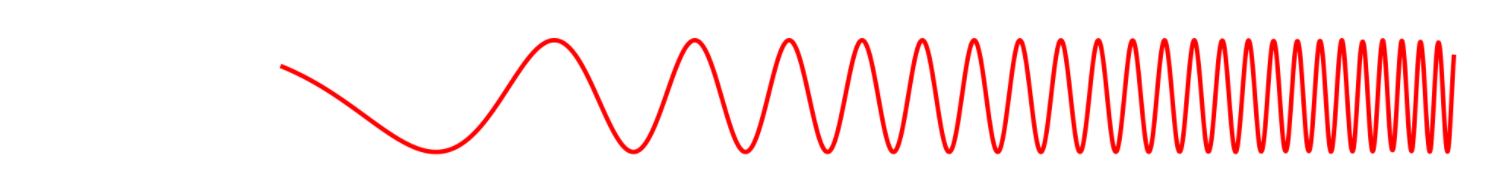

Qui si fa un piccolissimo passo avanti nella tecnica. Le onde radio sono onde, come quelle che si ottengono buttando un sasso nello stagno.

Butta un sasso nell’acqua e vedrai delle onde allontanarsi del punto in cui è caduto. Le onde radio sono la stessa cosa. Vengono emesse dall’antenna, ma non le vediamo. Possiamo solo immaginarle. Ci sono onde “lunghissime” e onde “ultracorte”. La lunghezza è quella che c’è fra una cresta e la successiva.

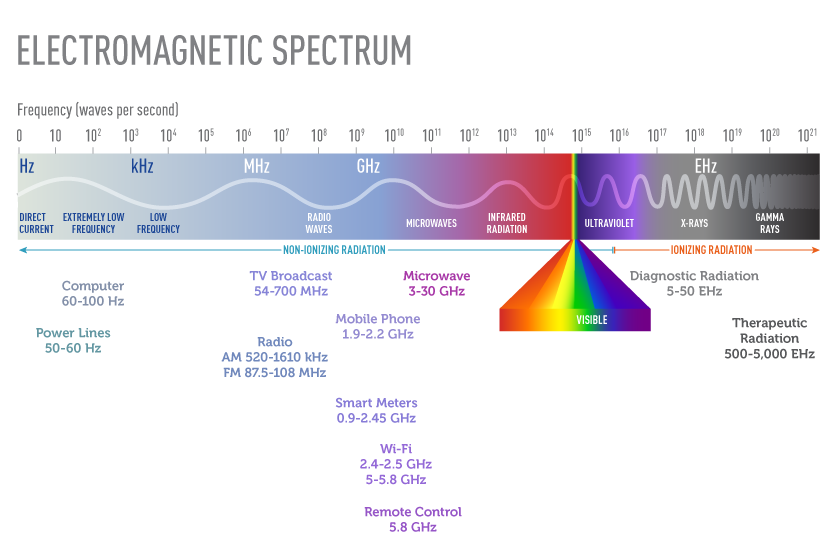

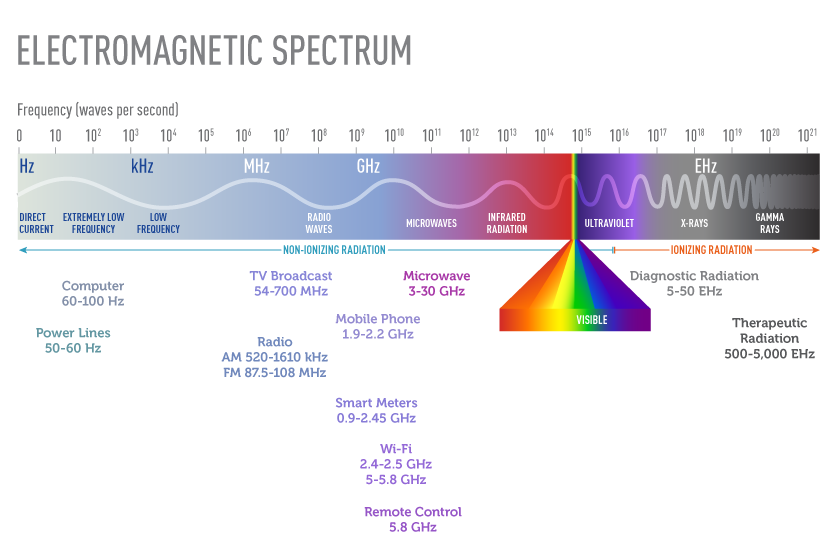

Le onde lunghissime sono quelle a sinistra, che ricordano una molla molto tirata. Quelle ultracorte sono quelle a destra, che ricordano una molla molto compressa. Ecco due immagini simili che visualizzano tutte le onde radio che ci circondano, alcune naturali e altre artificiali.

Si può facilmente vedere come fra la radiazione infrarossa e quella ultravioletta vi siano tutti i colori della luce visibile.

La frequenza delle onde la misuriamo in Hertz (Hz) o con i suoi multipli kHz (1000 Hz), MHz (1’000’000Hz), GHz (1’000 MHz), EHz (1’000 GHz).

In ordine crescente di frequenza abbiamo:

| 50 Hz |

Corrente elettrica casalinga |

onde lunghissime |

| 100 KHz |

Radio a lunghissima distanza |

onde lunghe |

| 1 MHz |

Radio a lunga distanza (AM) |

onde medie |

| 100MHz |

Radio locali (FM) |

onde corte |

| 1 GHz |

Televisione – cellulari |

onde ultracorte |

| 10 – 100 GHz |

RADAR |

microonde (millimetriche) |

oltre 1000 GHz

(oltre 1EHz) |

Luce infrarossa, visibile, ultravioletta |

onde micrometriche |

| oltre 1’000 EHz |

Radiazioni ionizzanti pericolose |

onde nanometriche |

Ogni tipo di emissione ha bisogno della sua frequenza, a seconda del tipo di servizio che deve fare. Le radio che trasmettono musica possono usare onde dalle lunghe alle medie alle corte. Quello che cambia è la distanza che le onde radio riescono a coprire. Le onde lunghe viaggiano fra i continenti. Le onde corte invece coprono solo le zone locali, ma hanno il vantaggio di offrire più “canali”. Più si sale di frequenza, verso le onde ultracorte, più aumentano i canali. Per avere più canali occorre salire di frequenza. Si perde in distanza (quindi servono più antenne) ma si guadagna in canali. Le televisioni con il passare dei decenni stanno usando onde sempre più corte, per avere più canali disponibili.

Le onde radio che vanno dalle lunghissime su su fino alle microonde e alla luce visibile non sono considerate pericolose, se non a potenze elevate (della potenza ne parliamo più avanti).

Dall’ultravioletto in poi le onde radio diventano radiazioni ionizzanti, e qui son dolori. Esempi di radiazioni ionizzanti sono i raggi X, e i raggi gamma. Con queste radiazioni occorre andarci piano, esporsi il meno possibile perché si va a rischio tumori o addirittura ustioni e morte.

Ma allora la frequenza è pericolosa? Sui pericoli derivanti dalle emissioni elettromagnetiche, ossia le onde radio, torniamo dopo. Possiamo però anticipare che, si, più sale la frequenza più aumentano i rischi, soprattutto dai raggi UV in poi. Ma in realtà tutto dipende dalla potenza.

POTENZA DELLE ONDE RADIO

Capita più o meno cos’è la frequenza, adesso parliamo della potenza. Il confronto con la voce è facile facile: se sussurro (bassa potenza) mi sente solo chi è vicino a me. Se urlo mi sentono anche persone dall’altro lato della valle. Le onde radio seguono lo stesso principio: se la potenza è bassa l’onda radio “si spegne” rapidamente e non va molto lontano. Se la potenza è alta l’onda radio può andare molto più lontano.

La potenza si misura in Watt (W) con i suoi sottomultipli (milliwatt mW) o multipli (kilowatt kW).

| pochi milliwatt (mW) |

telecomandi apricancello, giocattoli per bambini, telefoni cellulari |

| watt |

walkie talkie professionali, radio polizia e servizi pubblici |

| kilowatt (kW) |

emittenti radio / TV |

| megawatt (MW) |

armi a microonde o laser |

Solitamente si usa la potenza più bassa che garantisce il risultato. Nessuno penserebbe a fare un telecomando apri-cancello della potenza di qualche watt, sarebbe assurdo dato che pochi milliwatt sono più che sufficienti. Per coprire una vasta area con una emittente televisiva servono invece impianti da migliaia di watt (kilowatt).

La potenza rappresenta la vera FORZA con cui un’onda radio ci colpisce. Qualsiasi sia la sua frequenza, un’onda radio debole difficilmente potrà causare qualche danno significativo. Un’onda molto forte (molto potente) potrà invece generare danni, soprattutto se oltre ad essere molto forte (alta potenza) è anche molto veloce (alta frequenza).

Introduciamo quindi un concetto base: il pericolo è dato dalla combinazione fra alta potenza e alta frequenza.

Questo concetto lo si capisce molto bene se si pensa al forno a microonde che molti di noi hanno a casa.

Il forno a microonde genera lo stesso tipo di radiazione generata dai telefoni cellulari e dalle armi più o meno segrete che si usano per disperdere le folle o per abbattere missili a distanza. La differenza sta nella potenza.

- I nostri telefoni generano microonde a potenze bassissime, di pochi millesimi di Watt (pochi mW) e presentano rischi difficilmente quantificabili.

- I nostri forni a microonde generano potenze intermedie, di quasi DUEMILA Watt, quindi un milione di volte più potenti di un telefono cellulare. Siccome sono isolati perfettamente non presentano rischi quando sono chiusi. Ma all’interno del forno il rischio di danni alla persona è alto.

- Le armi a microonde generano potenze di svariati MILIONI DI WATT, quindi miliardi di volte più potenti dei nostri cellulari. Si tratta di armi, quindi qui il rischio è alto, garantito.

E’ evidente che non ha senso accomunare telefoni cellulari, forni a microonde e armi a microonde. Tutti usano le microonde ma a potenze diversissime. Chi ti dice: “pensa, il tuo cellulare è come un forno a microonde, ti cuoce il cervello” o è ignorante o cerca di fregarti. Sarebbe come dire che un pizzicotto e una pressa da 10 tonnellate sono la stessa cosa e fanno lo stesso danno.

A costo di essere noioso ti propongo un’altra similitudine. Tutti usiamo l’acqua, per bere e per lavarci. A nessuno verrebbe in mente di essere in pericolo.

Ma la stessa acqua, usata a pressione di 7000 bar può essere usata per tagliare lastre d’acciaio fino a 15mm di spessore, con il TAGLIO AD ACQUA.

Quindi concludiamo che l’acqua è pericolosa? La risposta è “dipende”. Se la beviamo dal bicchiere, la risposta è no. Se viene compressa a 7000 bar la risposta è SI. Dipende dalla potenza.

Adesso ci siamo fatti un’idea di cosa sono le onde radio, la frequenza e la potenza.

EVOLUZIONE TECNOLOGICA DEI CELLULARI

Abbiamo capito che i cellulari non sono altro che apparecchi radio forniti di tastiera e display.

I primissimi cellulari degli anni ’80 erano grossi e pesanti e la loro apparecchiatura radio era piuttosto rudimentale. Per garantire la comunicazione usava molta potenza, fino a 10W nei casi peggiori. L’emissione radio di onde EM era quindi piuttosto forte.

Poi, con il passare del tempo ed il progredire della tecnologia i cellulari sono diventati molto più “furbi”. Utilizzano potenze bassissime e solo quando serve. Se ad esempio noi facciamo una breve pausa fra una parola e l’altra, il cellulare abbassa di molto la potenza, quasi a zero, perché non ha niente da trasmettere. Inoltre la potenza di emissione del cellulare viene automaticamente regolata in base alla distanza dalla stazione base. Se la stazione base è vicina la potenza utilizzata è bassissima. Questo è vero anche per le antenne sui tralicci. La potenza viene emessa solo quando serve. Sono migliorate di molto anche le sezioni riceventi dei cellulari. Questo significa che il cellulare “prende meglio”. Ogni nuova tecnologia (1G, 2G, 3G, 4G, 5G) utilizza meno potenza della tecnologia precedente. Questo fatto è legato soprattutto ad una esigenza primaria: consumare meno batteria. Se il cellulare utilizza meno potenza la batteria dura di più, e questo è un vantaggio commerciale per chi produce e vende cellulari. Per questo i produttori di cellulari cercano soluzioni tecnologiche che consentano di utilizzare meno potenza, prolungando così la vita delle batterie e limitando nel contempo le emissioni EM. Con conseguente diminuzione dei rischi associati.

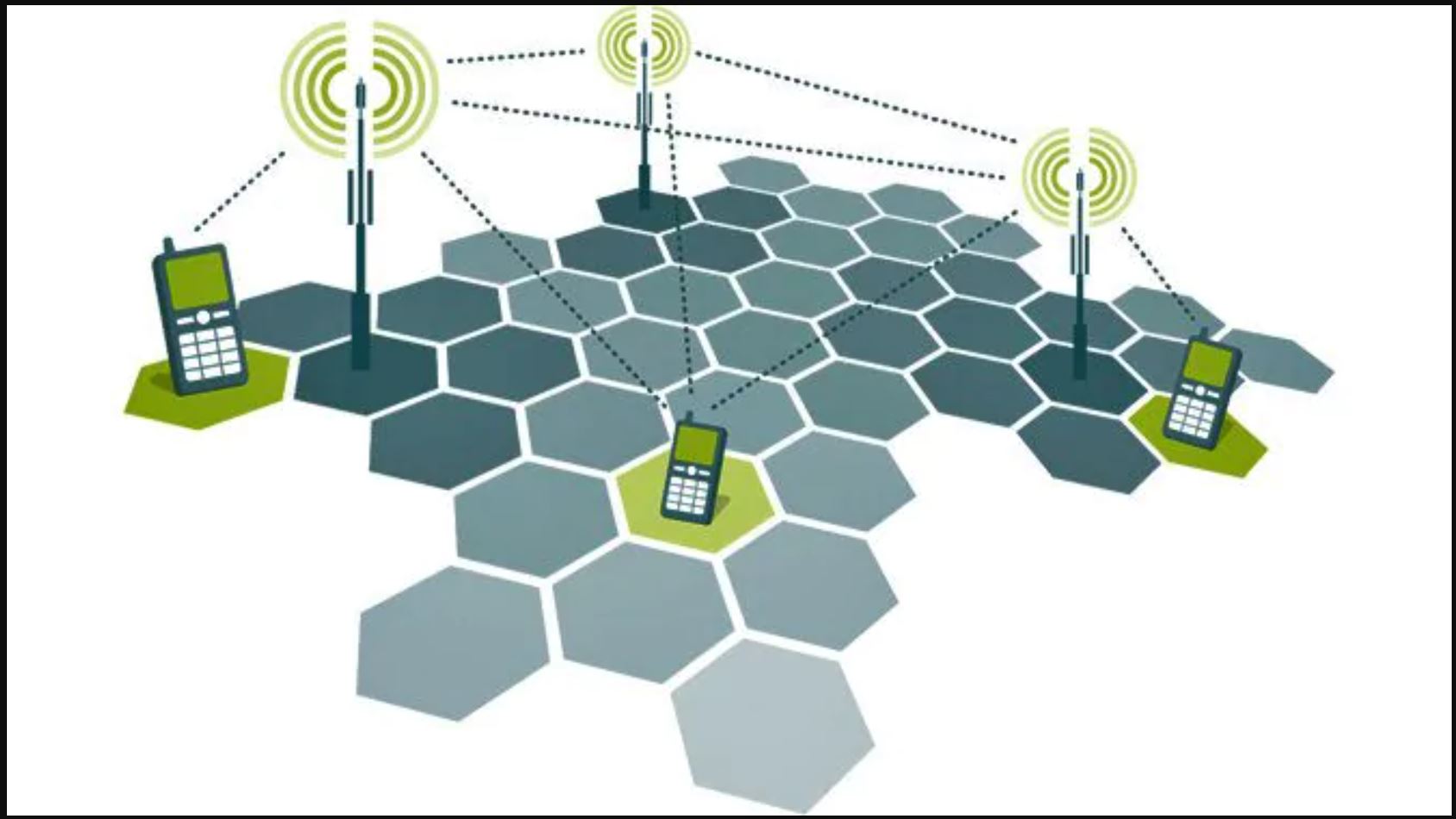

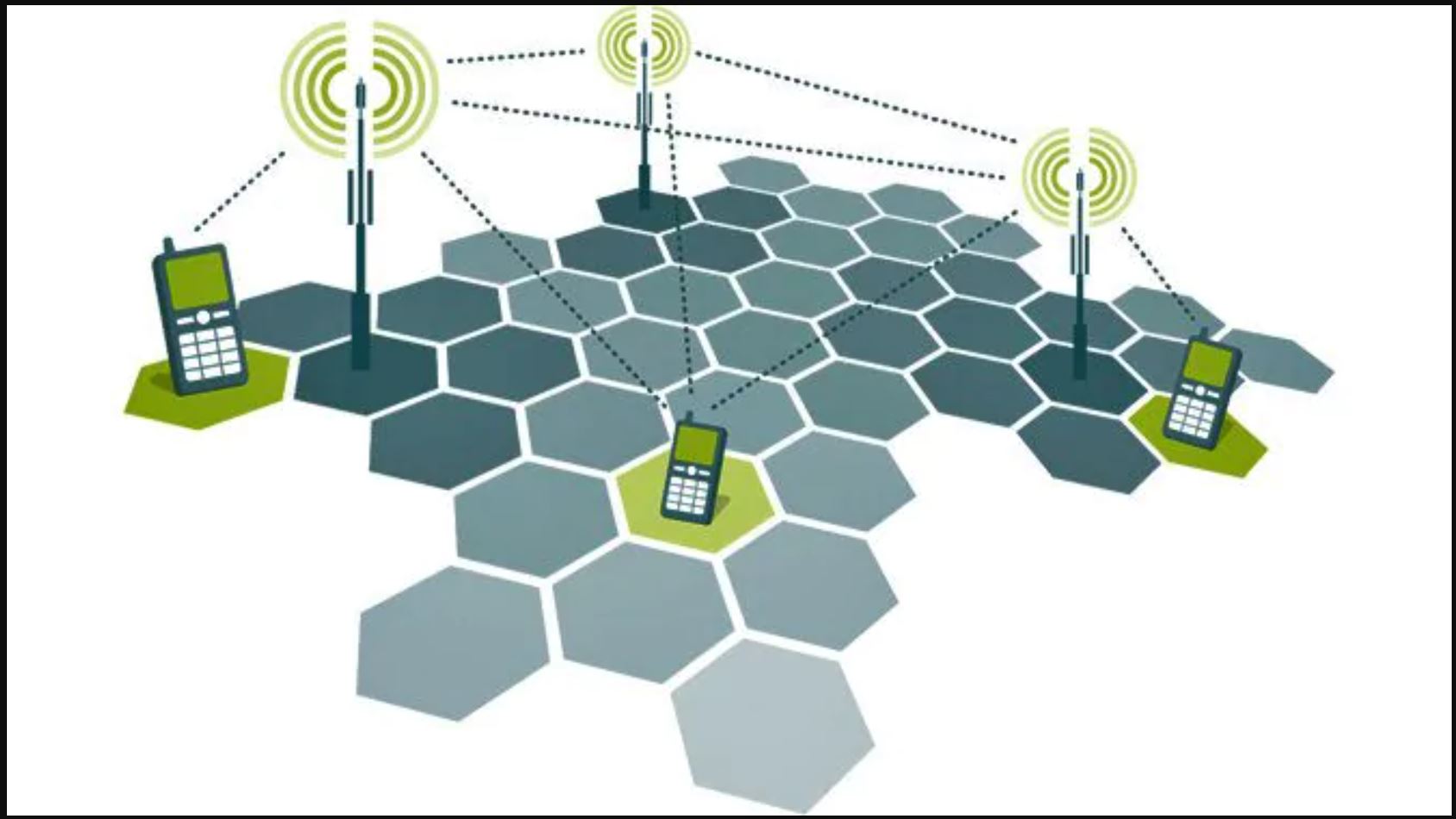

CELLE

La telefonia mobile si chiama “cellulare” proprio perché divide il territorio in molte “celle” contigue. Ogni cella ha la sua stazione base con relativa antenna. Quando il nostro cellulare si muove da una cella all’altra, mentre ci spostiamo a piedi o in auto, viene preso in carico dalla cella successiva, quindi si connette ad un’altra antenna. Perché questo meccanismo funzioni occorre che la potenza delle antenne sia limitata in modo da non interferire con la cella contigua. Questo è il motivo in base al quale la potenza delle stazioni basi e delle antenne dei cellulari è comunque una potenza limitata, per non creare interferenze con le celle circostanti. Nel caso del 5G questo meccanismo è spinto ancora più avanti: le celle sono molto più piccole rispetto al 4G e quindi le potenze devono essere ancora inferiori.

SI, MA DICONO CHE IL 5G E’ PIU’ PERICOLOSO

Questo secondo me è tutto da dimostrare. Sono stati usati tanti argomenti contro il 5G, per motivi che io non capisco.

FREQUENZE:

Il 5G utilizza in parte le stesse frequenze (700 MHz e 3GHz) delle tecnologie precedenti. Quindi, a rigor di logica, presenta gli stessi (eventuali) problemi delle generazioni precedenti (1G fino a 4G). Poi è previsto in futuro anche l’utilizzo della banda a 26GHz (gigahertz), che è quella che spaventa qualcuno. Ma anche qui siamo ancora nel campo delle radiazioni non ionizzanti, che alle bassissime potenze utilizzate dai cellulari non creano alcun problema.

ANTENNE

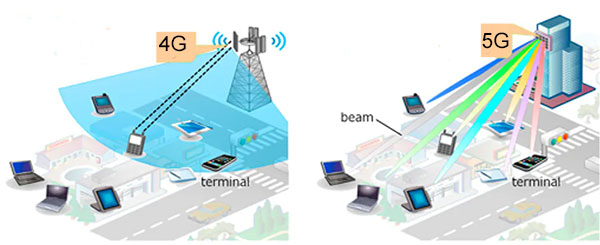

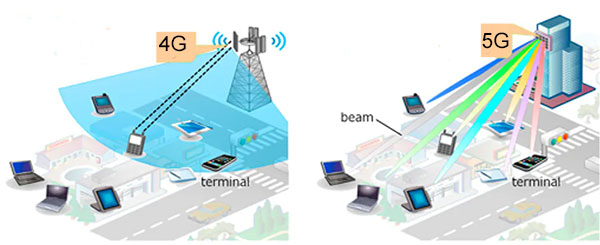

Una delle caratteristiche innovative e positiva del 5G è il sistema di “antenna intelligente”.

A differenza del 3G / 4G, dove l’antenna “illumina” con un ventaglio di onde radio tutta la sua zona di competenza, anche lì dove ci sono telefoni non attivi, l’antenna 5G è intelligente e convoglia le onde radio in forma di “raggi” (beam) solamente in direzione dei telefoni attivi. Questo, anche per chi si preoccupa della salute, è un grande passo avanti perché consente di non inviare onde radio dove non servono. Paradossalmente ci si deve preoccupare molto meno del 5G che del 4G.

Si ma con il 5G metteranno milioni di piccole antenne, saremo circondati.

Non nego che l’argomento possa essere di un certo effetto, ma ad una analisi più dettagliata è inconsistente.

Soprattutto nella banda più alta (ancora non usata in Italia) dei 26GHz le onde radio si propagano molto male e vengono fermate facilmente da qualsiasi ostacolo. Per questo l’idea è quella di usare molte antenne a bassissima potenza invece che poche antenne a potenza maggiore. Le celle, come detto in precedenza, saranno molto più piccole, e la potenza di conseguenza dovrà essere molto più bassa. Si, saremo circondati da tanti trasmettitori, ma a bassissima potenza.

Ho letto che con il 5G ci potranno controllare meglio perché le onde del 5G penetrano meglio nei muri.

Questo è un argomento totalmente infondato. Per quanto riguarda le bande di frequenza già usate dal 4G (700 MHz e 3 GHz) non ci sarà alcuna differenza. Mentre per quanto riguarda la banda più alta, a 26GHz, è un dato tecnico risaputo che più alta è la frequenza delle microonde più bassa è la loro capacità di penetrazione degli ostacoli.

Saremo circondati da miliardi di dispositivi IoT (Internet of Things) che generano campi EM pericolosi.

Anche questa è una affermazione totalmente infondata, per questi motivi:

- I dispositivi IoT non sono strettamente legati al 5G. Già oggi siamo circondati da dispositivi IoT: telecamere di sorveglianza, elettrodomestici, interruttori intelligenti, lampade intelligenti. La maggior parte di questi dispositivi si collegano al WiFi di casa, e sono del tutto indipendenti dal 5G. Altri dispositivi IoT arriveranno, e alcuni di loro si connetteranno alla rete 5G. Altri invece si connettono ad altre reti (LoRa), sulle stesse frequenze degli attuali cellulari (430 MHz, 868 MHz). Cito da un interessante articolo: “Una Low Power-Wide Area Network, per essere considerata applicabile in un’ambientazione Internet of Things deve avere delle ben precise caratteristiche, prima di tutto basso costo e bassi consumi. Infatti se si considera che in certe installazioni gli end-node device, o punti terminali di comunicazione come sorgenti di dati, potrebbero essere parecchie migliaia, i costi unitari sono il punto di partenza per determinare il ritorno dell’investimento, e i bassi consumi sono imprescindibili laddove la funzionalità dipende da batterie. “

- I dispositivi IoT generano un bassissimo flusso dati, e sono spesso alimentati a batteria. Si accendono al momento di trasmettere dati e poi si spengono. Sono in pratica normalmente inattivi, silenziosi. Ad esempio, un sensore di temperatura o umidità non genera un flusso continuo di dati, che sarebbe inutile e provocherebbe la scarica prematura della batteria. Diciamo che il sensore di temperatura o umidità invia i suoi dati una volta al minuto, per un tempo brevissimo. E poi torna a “dormire”. La stessa cosa vale più o meno per tutte le applicazioni IoT. E’ quindi del tutto infondata la paura di essere “circondati e bombardati” da un continuo flusso di onde radio generate dai dispositivi IoT.

PERICOLI DELLE ONDE RADIO

Le onde radio sono pericolose per la nostra salute? Alcune si, di sicuro. Già sappiamo che i raggi UV possono danneggiare la nostra pelle e provocare dei tumori. A maggior ragione le onde radio diventano pericolose man mano che saliamo di frequenza nel campo delle radiazioni ionizzanti.

RADIAZIONI IONIZZANTI

Per radiazioni ionizzanti si intendono quelle onde radio a frequenza altissima (maggiori di 10EHz) che vanno dai raggi UV ai raggi alfa, raggi X e raggi gamma. Qui si entra nel campo delle energie e delle radiazioni nucleari la cui pericolosità è conosciuta da quando sono state scoperte. Queste radiazioni possono essere usate per scopi medici (radiografie, TAC) ma solo occasionalmente e a dosi bassissime. Chi lavora a contatto con queste radiazioni deve proteggersi e utilizzare strumenti (dosimetri) che misurino l’assorbimento, per evitare esposizioni prolungate che sarebbero dannose. Ma le onde radio utilizzate per le comunicazioni hanno frequenze milioni di volte inferiori.

EMISSIONI NON IONIZZANTI

Le emissioni radio non ionizzanti sono quelle che vanno dai 50Hz (frequenza della corrente elettrica di casa) fino alla luce visibile. Sulla pericolosità delle emissioni non ionizzanti c’è una questione aperta da decenni. Si stanno conducendo studi sia sulla parte bassa dello spettro (i 50Hz di casa) che sulla parte alta (microonde per comunicazioni radio).

Un filone di studi riguarda i possibili effetti cancerogeni delle onde a bassissima frequenza (ELF), ossa quella della corrente di casa e dei tralicci ad alta tensione. I vari studi non hanno portato a risultati definitivi perché è estremamente difficile effettuare degli studi epidemiologici seri. Come in tutti gli studi medici occorre avere dei campioni che non vengono esposti e degli altri campioni che vengano esposti ad un solo elemento. E occorre che la sola differenza sia l’elemento in questione. Ma è impossibile trovare qualcuno che viva come noi, mangi come noi, respiri come noi, ma che non venga esposto a radiazioni a bassa frequenza. Tutti siamo esposti alle radiazioni emesse dagli impianti elettrici di casa, dell’ufficio, ovunque. Un altro problema è che le persone che vivono in diretta prossimità dl linee ad alta tensione e che sviluppano tumori o altre malattie raramente vivono sempre a contatto con quei campi EM. Potrebbero andare a lavorare in altri posti con altri agenti cancerogeni. O potrebbero incorrere in altri contatti (alimentazione, inquinamento atmosferico) che potrebbero provocare tumori o altre malattie. E’ questa estrema difficoltà ad effettuare i necessari studi epidemiologici che ha fino ad ora reso inconcludenti gli studi che cercano di mettere in relazione l’esposizione a emissioni ELF con l’insorgenza di tumori al cervello. Alcuni studi (questo) indicano una debolissima correlazione nel caso del glioma e praticamente nessuna correlazione nel caso del meningioma.

Altri filoni hanno studiato gli effetti delle onde radio a varie frequenze, dalle trasmissioni radio e TV ai telefoni cellulari e router WiFi, ma nessuno studio è arrivato a dimostrare correlazioni significative.

In definitiva, al momento attuale non è possibile dire con certezza che le emissioni radio possano provocare dei tumori. Le correlazioni identificate da alcuni studi sono talmente deboli da poter dire che il rischio è certamente di parecchi ordini di grandezza inferiore rispetto ad altre cause accertate di tumore e in genere di malattie potenzialmente mortali, come il fumo, l’inquinamento atmosferico, la sedentarietà, le cattive abitudini alimentari.

Da quel che ho capito fino ad oggi, e domani potrei cambiare idea, i veri problemi riguardanti la nostra salute riguardano ben altri aspetti.

Per quanto riguarda nello specifico il 5G, non si vede perché dovrebbe presentare problemi maggiori riguardo a quelli già eventualmente presentati dalle precedenti tecnologie (1G, 2G, 3G, 4G) che erano e sono anzi più pericolose sotto il profilo della potenza emessa.

Se davvero volessimo metterci al riparo dal pericolo (non dimostrato) delle emissioni EM, dovremmo:

- Smettere di utilizzare elettrodomestici di qualsiasi tipo nelle nostre case

- Vivere lontani da trasmettitori radio e tv di qualsiasi tipo

- Smettere di utilizzare telefoni cellulari di qualsiasi tipo

E’ del tutto evidente che simili soluzioni drastiche sono possibili solo vivendo isolati dal mondo lontani da ogni forma possibile di civiltà, rinunciando ad utilizzare qualsiasi forma di elettricità, Possibile, certo, ma non facilmente realizzabile.

Nel momento stesso in cui accettiamo di vivere in una città, grande o piccola che sia, utilizzando elettrodomestici e telefoni cellulari, in quel momento ci troveremo esposti a numerosi e inevitabili campi EM.

Quindi a mio parere il vero problema non è il 5G, ma la civiltà tecnologica tutta.

La vita è colma di rischi, da sempre. Rischiamo malattie, incidenti, inquinamenti. Spesso siamo costretti a barattare parte della nostra sicurezza in cambio di una qualche forma di stabilità lavorativa. Molti lavori mettono a rischio la nostra salute, in un modo o nell’altro. E lo stesso vivere in determinate aree ci sottopone a forti dosi di inquinamento atmosferico o di altro tipo. E’ giusto preoccuparsi di minimizzare le fonti di inquinamento, essere critici ed analizzare tutto. Ma nel fare questo occorre stabilire delle priorità, e concentrare la nostra attenzione soprattutto a quei fenomeni che per loro stessa natura comportano i più alti e documentati rischi per la nostra salute. Al momento, salvo successivi approfondimenti, il rischio 5G è un lusso che possono permettersi solo coloro che vivono al di fuori di aree altrimenti inquinate. Ma chi vive, ad esempio, in pianura Padana, ha molti altri motivi di preoccupazione, decisamente più incisivi e dimostrati.